解读CPU、GPU和NPU应用及功能特点

发布时间:2025/4/25 8:06:19 访问次数:42

在当今信息技术的快速发展背景下,中央处理器(CPU)、图形处理器(GPU)以及神经处理器(NPU)作为计算机领域中不可或缺的关键组件,在不同应用场景中发挥着各自特有的功能和优势。这三种处理器的设计初衷和架构特点形成了它们在并行处理、任务专用性和计算效率等方面的显著差异。

首先,中央处理器(CPU)作为计算机的核心组件,其功能强调通用性和灵活性。

CPU主要负责指令的获取、解码和执行,它擅长处理各种复杂的计算任务,比如操作系统管理、应用程序运行等。传统的CPU由少量的高性能核心组成,具有较高的时钟频率和较强的单线程性能。因此,在处理需要高频率响应的任务时,CPU表现出较强的优势。此外,现代CPU还集成了多级缓存、高速内存接口和各种指令集扩展,进一步提升了其计算效率。

CPU在面对大规模并行计算任务时,相对较弱。

由于其设计上专注于低延迟和高单线程性能,当需要处理大量相似或相对独立的计算时,CPU的性能往往无法与其他专用处理器相媲美。例如,在视频编码、图像处理和机器学习等领域,单一CPU无法高效地处理大规模的数据并行任务。因此,随着技术的不断发展,图形处理器(GPU)应运而生,以满足这一需求。

GPU的设计主要是为了解决图形渲染和图像处理中的高并发计算问题。

与CPU相比,GPU具备数量众多的计算核心,能够同时处理大量的并行任务。这种大规模并行处理能力,使得GPU在图像处理、科学计算以及深度学习等领域获得广泛应用。在深度学习中,GPU因其强大的矩阵计算能力而被广泛用于训练神经网络。在训练过程中,神经网络的权重更新需要处理大量的数据并进行复杂的矩阵运算,GPU能够高效地完成这些任务,从而显著缩短训练时间。

尽管GPU在图形处理和并行计算方面表现出色,但其在特定任务上的灵活性和能效比仍有待提高。

这促使了神经处理器(NPU)的出现。NPU专为机器学习和人工智能计算优化而设计,重点在于加速神经网络推理和训练过程。NPU通过专门的硬件架构,例如极简的算子设计和高效的数据流导向,能够更高效地处理深度学习模型中的复杂计算。这种专用性使得NPU不仅在性能上优于传统CPU和GPU,而且在功耗和处理速度上也展现出独特的优势。

NPU还配备了灵活的存储架构,以支持低延迟的内存访问和高带宽的数据输入输出。

这一特性使得NPU在实际应用中能够减少数据传输的瓶颈,提高整体计算效率。而且随着人工智能的快速发展,NPU能够更好地支撑端侧计算需求,满足实时处理和低延迟的应用场景。这在自动驾驶、智能语音助手、物联网设备等迅速发展的领域尤为重要。

除了各自的核心优势,这三种处理器在实际应用中常常存在重叠。具体而言,现代计算系统中有时会同时集成CPU、GPU和NPU,以实现更高效的多任务处理。例如,在深度学习框架中,CPU可以负责数据预处理和模型部署等任务,而GPU负责模型的训练,而NPU则专注于推理阶段的加速。这种分工合作的模式能够充分发挥各个处理器的优势,最大限度地提高系统性能。

此外,随着技术的不断演进,处理器的功能也在不断融合。例如,许多现代GPU开始集成越来越多的AI计算功能,能够更好地支持机器学习任务。同时,有些CPU也在引入针对机器学习的指令集,以提高处理速度与效率。这种趋势不仅加速了计算领域的进步,同时也使得开发者和工程师在选择硬件时面临更多的选择和挑战。

在未来的发展中,CPU、GPU和NPU之间的边界将会愈加模糊,三者将共同促进计算能力的进步。新一代计算平台将会利用云计算和边缘计算的结合,依托于多样化的硬件架构,为大数据分析、深度学习和实时处理等应用场景提供更高效的解决方案。随着智能化应用场景的不断扩大,日益复杂的计算需求将推动这些处理器不断进化,最终实现更高效、更智能的计算平台。

在当今信息技术的快速发展背景下,中央处理器(CPU)、图形处理器(GPU)以及神经处理器(NPU)作为计算机领域中不可或缺的关键组件,在不同应用场景中发挥着各自特有的功能和优势。这三种处理器的设计初衷和架构特点形成了它们在并行处理、任务专用性和计算效率等方面的显著差异。

首先,中央处理器(CPU)作为计算机的核心组件,其功能强调通用性和灵活性。

CPU主要负责指令的获取、解码和执行,它擅长处理各种复杂的计算任务,比如操作系统管理、应用程序运行等。传统的CPU由少量的高性能核心组成,具有较高的时钟频率和较强的单线程性能。因此,在处理需要高频率响应的任务时,CPU表现出较强的优势。此外,现代CPU还集成了多级缓存、高速内存接口和各种指令集扩展,进一步提升了其计算效率。

CPU在面对大规模并行计算任务时,相对较弱。

由于其设计上专注于低延迟和高单线程性能,当需要处理大量相似或相对独立的计算时,CPU的性能往往无法与其他专用处理器相媲美。例如,在视频编码、图像处理和机器学习等领域,单一CPU无法高效地处理大规模的数据并行任务。因此,随着技术的不断发展,图形处理器(GPU)应运而生,以满足这一需求。

GPU的设计主要是为了解决图形渲染和图像处理中的高并发计算问题。

与CPU相比,GPU具备数量众多的计算核心,能够同时处理大量的并行任务。这种大规模并行处理能力,使得GPU在图像处理、科学计算以及深度学习等领域获得广泛应用。在深度学习中,GPU因其强大的矩阵计算能力而被广泛用于训练神经网络。在训练过程中,神经网络的权重更新需要处理大量的数据并进行复杂的矩阵运算,GPU能够高效地完成这些任务,从而显著缩短训练时间。

尽管GPU在图形处理和并行计算方面表现出色,但其在特定任务上的灵活性和能效比仍有待提高。

这促使了神经处理器(NPU)的出现。NPU专为机器学习和人工智能计算优化而设计,重点在于加速神经网络推理和训练过程。NPU通过专门的硬件架构,例如极简的算子设计和高效的数据流导向,能够更高效地处理深度学习模型中的复杂计算。这种专用性使得NPU不仅在性能上优于传统CPU和GPU,而且在功耗和处理速度上也展现出独特的优势。

NPU还配备了灵活的存储架构,以支持低延迟的内存访问和高带宽的数据输入输出。

这一特性使得NPU在实际应用中能够减少数据传输的瓶颈,提高整体计算效率。而且随着人工智能的快速发展,NPU能够更好地支撑端侧计算需求,满足实时处理和低延迟的应用场景。这在自动驾驶、智能语音助手、物联网设备等迅速发展的领域尤为重要。

除了各自的核心优势,这三种处理器在实际应用中常常存在重叠。具体而言,现代计算系统中有时会同时集成CPU、GPU和NPU,以实现更高效的多任务处理。例如,在深度学习框架中,CPU可以负责数据预处理和模型部署等任务,而GPU负责模型的训练,而NPU则专注于推理阶段的加速。这种分工合作的模式能够充分发挥各个处理器的优势,最大限度地提高系统性能。

此外,随着技术的不断演进,处理器的功能也在不断融合。例如,许多现代GPU开始集成越来越多的AI计算功能,能够更好地支持机器学习任务。同时,有些CPU也在引入针对机器学习的指令集,以提高处理速度与效率。这种趋势不仅加速了计算领域的进步,同时也使得开发者和工程师在选择硬件时面临更多的选择和挑战。

在未来的发展中,CPU、GPU和NPU之间的边界将会愈加模糊,三者将共同促进计算能力的进步。新一代计算平台将会利用云计算和边缘计算的结合,依托于多样化的硬件架构,为大数据分析、深度学习和实时处理等应用场景提供更高效的解决方案。随着智能化应用场景的不断扩大,日益复杂的计算需求将推动这些处理器不断进化,最终实现更高效、更智能的计算平台。

上一篇:高性能智能大小脑融合解决方案

上一篇:单芯片舱驾一体域控制器详解

热门点击

热门点击

- InnoSwitch3-AQ开

- MPS电源管理解决方案

- 首款晶圆边缘刻蚀设备Primo Halona

- 全新系列全桥/H桥集成电路(I

- AI机器人多元未来发展前景及&

- ECC DDR4 SODIMM内存条技术参数

- 全新 3225尺寸(3.2 x

- 高性能计算关键存储高带宽内存(

- 双路 S5000C 处理器应用

- TNPV 高压表面贴装电阻

推荐技术资料

推荐技术资料

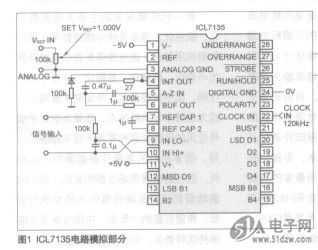

- 自制智能型ICL7135

- 表头使ff11CL7135作为ADC,ICL7135是... [详细]

公网安备44030402000607

公网安备44030402000607