端侧 AI 芯片的架构设计及关键核心技术

发布时间:2025/4/15 8:11:02 访问次数:131

端侧 AI 芯片的架构设计及关键核心技术

随着人工智能技术的发展,端侧 AI(Edge AI)逐渐成为了现代计算架构的重要组成部分。端侧 AI 指在数据产生源或终端设备上直接进行计算和推理,无需将数据传输到云端进行处理。

这一概念的实现依赖于高效能和低功耗的 AI 芯片,其架构设计和核心技术的创新性成为了推动这一领域进步的关键因素。

一、端侧 AI 芯片的架构设计

1. 分布式计算架构

端侧 AI 芯片通常采用分布式计算架构,该架构能够将计算任务分散到多个处理单元上,提高并行处理的能力。这种设计不仅提升了计算性能,还有效降低了功耗。

在硬件层面,这种架构可以通过集成多核处理器、GPU 和专用的 AI 加速器(如TPU)来实现。各处理单元之间的高效协同及数据共享是实现高性能计算的关键。

2. 异构计算架构

端侧 AI 芯片还普遍采用异构计算架构,即将不同类型的处理器(如 CPU、GPU、FPGA 和 ASIC)结合在一起,针对不同类型的计算任务进行优化。

异构架构能够充分发挥各处理器在特定计算任务上的优势,以实现更高的性能和更低的能耗。例如,CPU适合复杂的控制逻辑和数据预处理,而GPU则更擅长并行处理和深度学习模型的推理。

3. 内存架构设计

在端侧 AI 芯片中,内存架构的设计亦至关重要。传统计算架构通常采用层级式内存(如 L1、L2、L3 缓存)来实现数据的快速存取。然而,随着 AI 算法尤其是深度学习模型的不断复杂化,单一的层级缓存结构逐渐暴露出性能瓶颈。为了提高数据访问效率,设计多级、高带宽、低延迟的内存架构尤其重要,包括片上内存、DRAM 和非易失性存储器等的结合利用。

4. 硬件加速单元的集成

针对深度学习和其他 AI 计算任务的特殊需求,设计者常常会在端侧 AI 芯片内部集成专用的硬件加速单元。例如,卷积神经网络(CNN)在图像处理中的广泛应用,促使芯片设计中加入专门的卷积处理单元,以加速卷积运算。此外,量化技术的应用同样推动了这些加速器的设计,使得模型能够在更小的数据表示上依然保持高性能。

二、关键核心技术

1. 深度学习模型压缩

为了满足端侧设备的计算和能耗限制,模型压缩技术是实现高效推理的核心技术之一。常见的模型压缩方法包括剪枝、量化和知识蒸馏。通过剪枝技术,可以将冗余的网络结构去除,从而减少模型的参数量和计算量;量化则是将浮点数权重转换为低位数表示,降低内存占用和计算复杂度;知识蒸馏通过将复杂模型的知识迁移到简单模型中,帮助简化网络结构,同时保持性能。

2. 边缘计算优化算法

在端侧 AI 应用中,算法的有效性直接影响到芯片的使用效果。为此,研究人员开发了一系列边缘计算优化算法,以降低计算负担和延迟,提高响应速度。这些算法通常基于数据流优化、负载均衡和动态全局优化等策略,能在不同的网络条件和计算资源下灵活调整计算策略,确保实时性和准确性并存。

3. 高效能能量管理技术

端侧设备通常面临严苛的能耗限制,因此高效能的电源管理技术是端侧 AI 芯片不可或缺的一部分。这些技术包括动态电压频率调整(DVFS)、睡眠模式以及电源门控等。通过实时监测计算负载,智能调整工作频率和电压,可以最大限度地降低能耗,延长设备的使用寿命。

4. 自适应计算架构

自适应计算架构的提出,旨在应对多变的计算需求和环境变化。该架构通过动态调整硬件资源分配和计算策略,使得端侧 AI 芯片能够根据实际负载实时优化性能。例如,在深度学习推理过程中,芯片可以根据输入数据的复杂性选择不同的计算路径,灵活切换处理器和加速器,确保最优的处理效率。

5. 安全性技术

在数据隐私日益受到关注的背景下,端侧 AI 芯片的安全性技术同样重要。鉴于端侧 AI 芯片常常处理敏感的个人数据,如人脸识别和语音助手等应用场景,必须采取加密技术和安全计算方法来保护用户隐私。另外,安全启动、硬件隔离和可信执行环境(TEE)等技术能够有效防止未经授权的访问和漏洞利用,保障芯片的整体安全性。

端侧 AI 芯片在架构设计上强调高性能、低功耗与灵活性,而在关键核心技术上则覆盖了模型压缩、边缘计算优化、能量管理等多个方面。通过对这些技术的不断创新和优化,端侧 AI 芯片正逐渐塑造出未来智能设备的计算形态,推动更广泛的应用场景落地。

端侧 AI 芯片的架构设计及关键核心技术

随着人工智能技术的发展,端侧 AI(Edge AI)逐渐成为了现代计算架构的重要组成部分。端侧 AI 指在数据产生源或终端设备上直接进行计算和推理,无需将数据传输到云端进行处理。

这一概念的实现依赖于高效能和低功耗的 AI 芯片,其架构设计和核心技术的创新性成为了推动这一领域进步的关键因素。

一、端侧 AI 芯片的架构设计

1. 分布式计算架构

端侧 AI 芯片通常采用分布式计算架构,该架构能够将计算任务分散到多个处理单元上,提高并行处理的能力。这种设计不仅提升了计算性能,还有效降低了功耗。

在硬件层面,这种架构可以通过集成多核处理器、GPU 和专用的 AI 加速器(如TPU)来实现。各处理单元之间的高效协同及数据共享是实现高性能计算的关键。

2. 异构计算架构

端侧 AI 芯片还普遍采用异构计算架构,即将不同类型的处理器(如 CPU、GPU、FPGA 和 ASIC)结合在一起,针对不同类型的计算任务进行优化。

异构架构能够充分发挥各处理器在特定计算任务上的优势,以实现更高的性能和更低的能耗。例如,CPU适合复杂的控制逻辑和数据预处理,而GPU则更擅长并行处理和深度学习模型的推理。

3. 内存架构设计

在端侧 AI 芯片中,内存架构的设计亦至关重要。传统计算架构通常采用层级式内存(如 L1、L2、L3 缓存)来实现数据的快速存取。然而,随着 AI 算法尤其是深度学习模型的不断复杂化,单一的层级缓存结构逐渐暴露出性能瓶颈。为了提高数据访问效率,设计多级、高带宽、低延迟的内存架构尤其重要,包括片上内存、DRAM 和非易失性存储器等的结合利用。

4. 硬件加速单元的集成

针对深度学习和其他 AI 计算任务的特殊需求,设计者常常会在端侧 AI 芯片内部集成专用的硬件加速单元。例如,卷积神经网络(CNN)在图像处理中的广泛应用,促使芯片设计中加入专门的卷积处理单元,以加速卷积运算。此外,量化技术的应用同样推动了这些加速器的设计,使得模型能够在更小的数据表示上依然保持高性能。

二、关键核心技术

1. 深度学习模型压缩

为了满足端侧设备的计算和能耗限制,模型压缩技术是实现高效推理的核心技术之一。常见的模型压缩方法包括剪枝、量化和知识蒸馏。通过剪枝技术,可以将冗余的网络结构去除,从而减少模型的参数量和计算量;量化则是将浮点数权重转换为低位数表示,降低内存占用和计算复杂度;知识蒸馏通过将复杂模型的知识迁移到简单模型中,帮助简化网络结构,同时保持性能。

2. 边缘计算优化算法

在端侧 AI 应用中,算法的有效性直接影响到芯片的使用效果。为此,研究人员开发了一系列边缘计算优化算法,以降低计算负担和延迟,提高响应速度。这些算法通常基于数据流优化、负载均衡和动态全局优化等策略,能在不同的网络条件和计算资源下灵活调整计算策略,确保实时性和准确性并存。

3. 高效能能量管理技术

端侧设备通常面临严苛的能耗限制,因此高效能的电源管理技术是端侧 AI 芯片不可或缺的一部分。这些技术包括动态电压频率调整(DVFS)、睡眠模式以及电源门控等。通过实时监测计算负载,智能调整工作频率和电压,可以最大限度地降低能耗,延长设备的使用寿命。

4. 自适应计算架构

自适应计算架构的提出,旨在应对多变的计算需求和环境变化。该架构通过动态调整硬件资源分配和计算策略,使得端侧 AI 芯片能够根据实际负载实时优化性能。例如,在深度学习推理过程中,芯片可以根据输入数据的复杂性选择不同的计算路径,灵活切换处理器和加速器,确保最优的处理效率。

5. 安全性技术

在数据隐私日益受到关注的背景下,端侧 AI 芯片的安全性技术同样重要。鉴于端侧 AI 芯片常常处理敏感的个人数据,如人脸识别和语音助手等应用场景,必须采取加密技术和安全计算方法来保护用户隐私。另外,安全启动、硬件隔离和可信执行环境(TEE)等技术能够有效防止未经授权的访问和漏洞利用,保障芯片的整体安全性。

端侧 AI 芯片在架构设计上强调高性能、低功耗与灵活性,而在关键核心技术上则覆盖了模型压缩、边缘计算优化、能量管理等多个方面。通过对这些技术的不断创新和优化,端侧 AI 芯片正逐渐塑造出未来智能设备的计算形态,推动更广泛的应用场景落地。

热门点击

热门点击

- 24位精密数据采集 (DAQ) μModul

- InnoSwitch3-AQ开

- MPS电源管理解决方案

- 全新系列全桥/H桥集成电路(I

- AI机器人多元未来发展前景及&

- ECC DDR4 SODIMM内存条技术参数

- 全新 3225尺寸(3.2 x

- 高性能计算关键存储高带宽内存(

- 双路 S5000C 处理器应用

- TNPV 高压表面贴装电阻

推荐技术资料

推荐技术资料

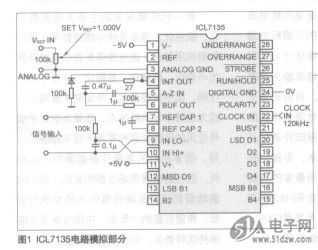

- 自制智能型ICL7135

- 表头使ff11CL7135作为ADC,ICL7135是... [详细]

公网安备44030402000607

公网安备44030402000607